Dans l’article précédent [1], j’ai tenté de définir ce que l’on peut appeler une « bonne évaluation » au regard de la conception que l’on se fait des apprentissages des étudiants.

Cependant, au-delà de ces aspects conceptuels, il existe d’autres critères qui doivent être pris en compte pour définir une « bonne évaluation ».

Ce sont :

– la validité ;

– la fidélité ;

– l’objectivité ;

– la faisabilité.

La validité

La méthode que j’ai choisie (ou que l’on m’a imposée) permet-elle réellement d’évaluer ce que je souhaite évaluer ?

Quelques exemples :

- Est-ce que le cas clinique proposé pour le CSCT est suffisamment contextualisé pour correspondre à une situation réelle, ou bien est-il une simple compilation de faits ou d’informations ?

- Est-ce que les situations de simulation auxquelles je confronte les étudiants pour les évaluer en TP sont suffisamment valides pour estimer leur capacité à prendre des décisions dans des situations cliniques réelles ?

Les QCM (questions à choix multiples) peuvent présenter un haut niveau de validité pour évaluer des connaissances déclaratives, mais un très faible niveau de validité pour évaluer le raisonnement de l’étudiant.

La première tâche est donc de vérifier que l’outil d’évaluation est bien cohérent avec l’intention et le niveau visé.

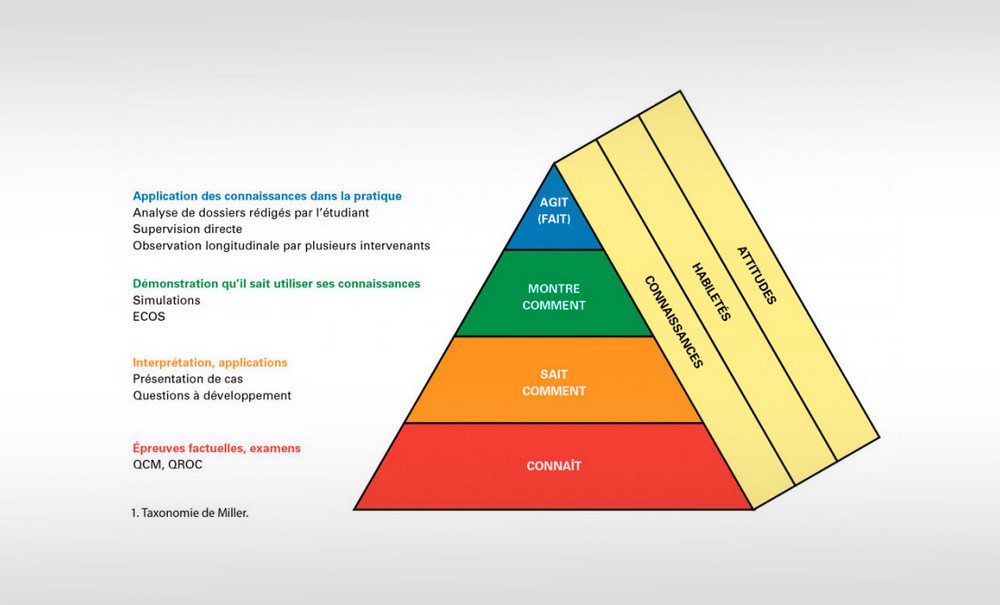

On peut s’aider d’outils appelés « taxonomies ». Deux ont été proposées et sont très utilisées : celle de Bloom et celle de Miller.

Bloom [2] identifie trois domaines : cognitif, psycho-affectif et psychomoteur, et trois niveaux renvoyant à l’usage de différents outils d’évaluation (tableau 1).

Le niveau 1, dans le domaine cognitif, consiste à mémoriser des connaissances. Les QCM ou les QROC (questions à réponses ouvertes courtes) présentent un bon niveau de validité dans ce cas.

Le niveau 2 nécessite plutôt des cas cliniques « progressifs »…