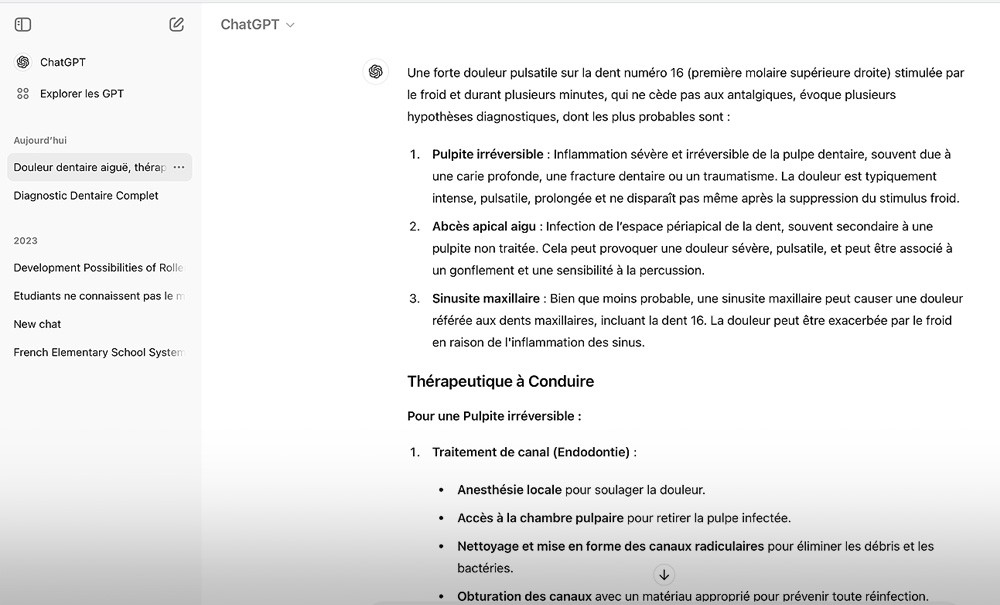

Cet été, comme chaque été, les étudiants en dentaire ayant validé leur 5e année vont pouvoir assurer leur premier remplacement, en toute autonomie. Livrés à eux-mêmes, ils vont devoir réaliser seuls les bons diagnostics, prendre des décisions thérapeutiques et les mettre en œuvre dans les différentes situations auxquelles ils seront confrontés. Sans encadrant à leur côté, certains auront peut-être la tentation de rechercher un soutien tutoriel parmi les outils technologiques auxquels ils sont déjà rompus, et donc pourquoi pas l’aide d’une intelligence artificielle ?

Les auteurs de l’étude rapportée ont testé le désormais célèbre ChatGPT sur l’exactitude de ses diagnostics et stratégies thérapeutiques proposés par rapport à l’approbation de cliniciens sur 12 cas cliniques de pathologies orales. L’étude rétrospective qu’ils ont construite à dessein a soumis à ChatGPT 3,5 des scénarios rédigés par les auteurs pour chacun des cas traités par le département de chirurgie orale et maxillo-faciale de l’Université d’Ordu, en Turquie, à partir des données archivées.

La première question posée à l’IA était de proposer, pour chaque cas, trios hypothèses thérapeutique classées par ordre de probabilité. Une deuxième question demandait alors la proposition d’un plan de traitement pour l’hypothèse la plus probable. Ensuite, 30 médecins cliniciens parmi lesquels 12 chirurgiens et 18 radiologues ont évalué la complexité des scénarios proposés et exprimé leur niveau d’agrément avec les propositions de ChatGPT concernant les hypothèses diagnostiques formulées et les traitements proposés. Leurs réponses furent ainsi collectées à l’aide d’une échelle de Linkers à 5 niveaux. Cet outil, très utilisé dans le domaine des sondages, permet d’obtenir des résultats de l’ordre du « ressenti » faciles à exploiter sur un sujet donné. Les réponses collectées sous forme d’échelle…